PointWorld | arxiv 2026.01.07 | Paper Reading

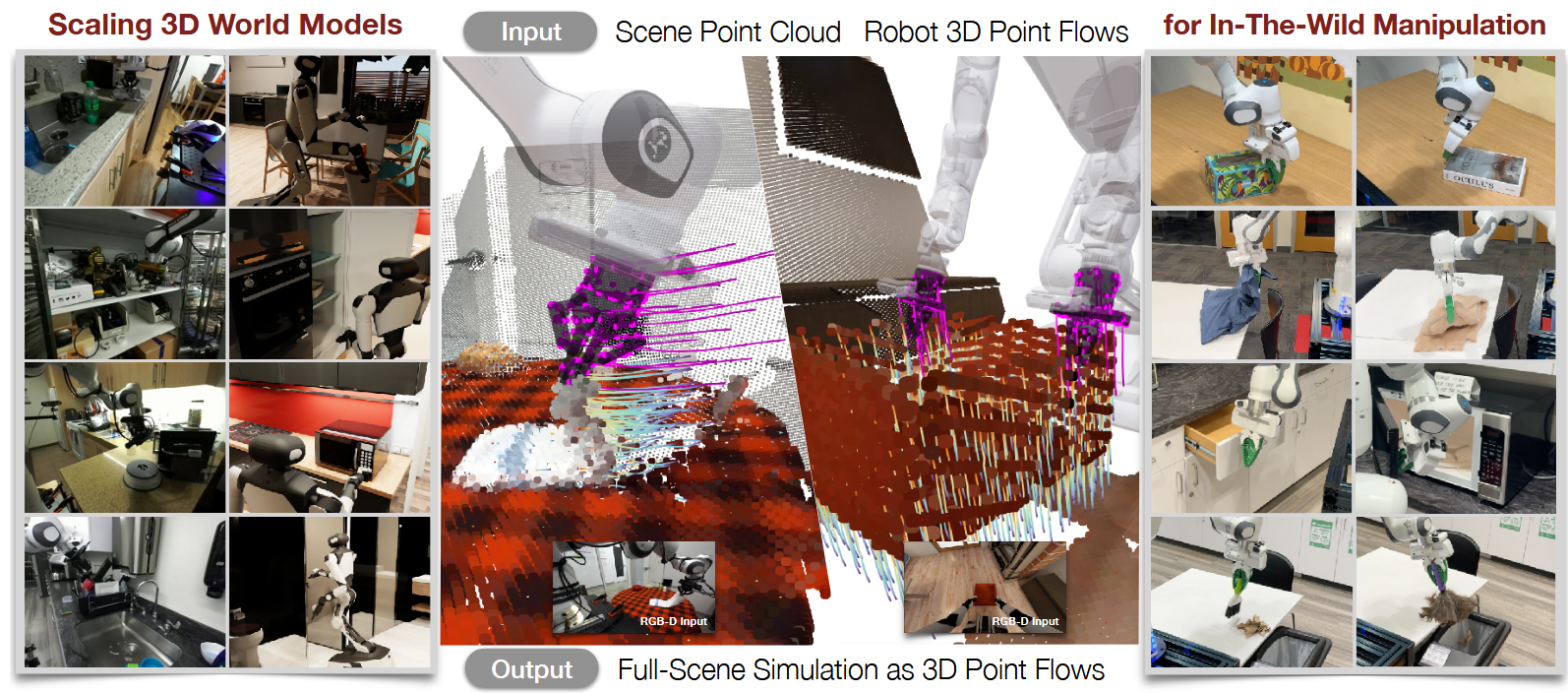

PointWorld: Scaling 3D World Models for In-The-Wild Robotic Manipulation

这篇文章提出了一个大型预训练的三维世界模型,模型能够根据静态点云及与具体形态无关的机器人动作描述预测全场景三维点流运动,同时作者构建了大规模三维动力学建模数据集,涵盖真实与仿真环境中单臂、双臂、全身及移动操作等多种交互形态。该模型经多样化数据预训练后,仅需在开放场景中捕获的单帧RGB-D图像,无需额外数据或微调,即可在实体硬件上实现多种操作行为。

| 工作类型(首次/改进) | 技术路线 | 创新点 | 日期 |

|---|---|---|---|

| 首次 | World Model+3D point cloud | Foundation World Model | 2026-01-07 |

1.What?

一个大型预训练三维世界模型

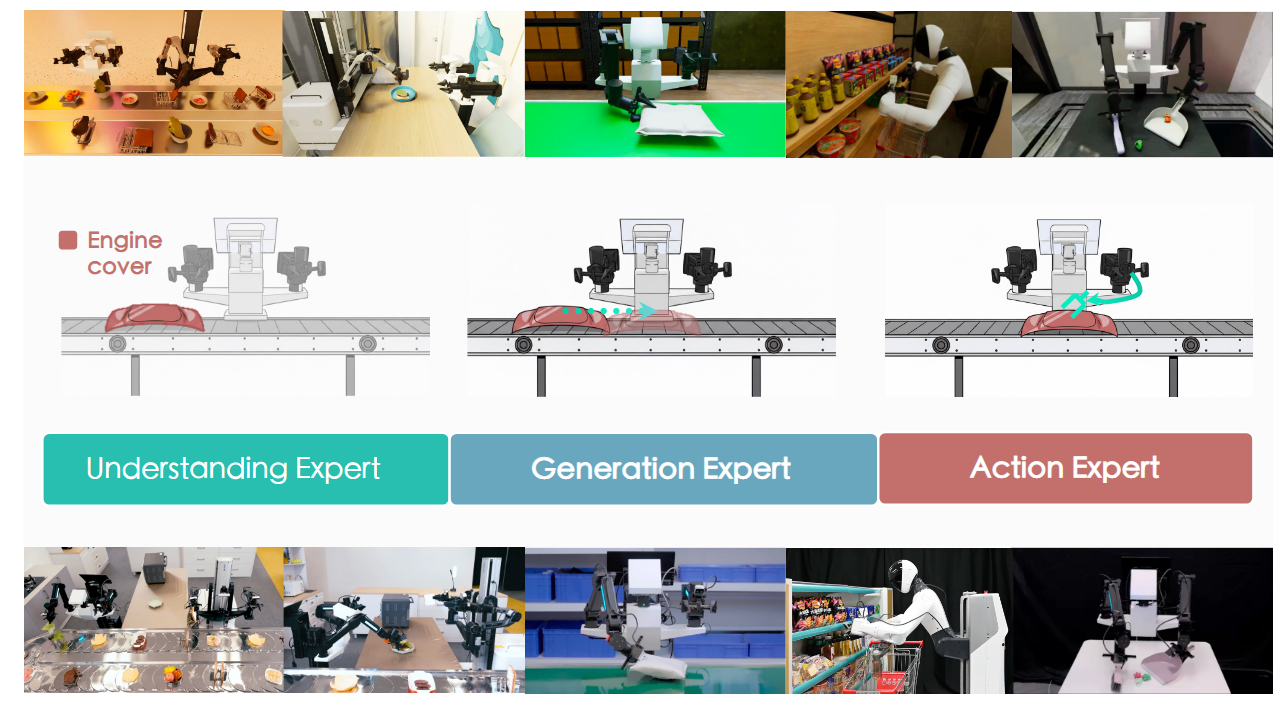

构建了一个开放世界环境中真实与仿真机器人操控的大规模数据集——借助三维视觉与仿真环境的最新进展,数据集总计约200万条轨迹、500小时时长,覆盖单臂Franka机器人及双仿人手机器人平台。

2.Why?

泛化性问题:物理的模型虽能实现高精度预测,却面临仿真与现实的差距,且需要针对特定环境进行定制化建模。

精度不够:基于学习的动力学模型通过观察交互进行学习来应对这一问题,但往往依赖于领域特定的归纳偏置(如完全可观测性、物体先验或材质设定)。

无动作操控:大规模训练的视频生成模型能够生成逼真的预测,但缺乏显式的动作条件化机制,且在物理一致性上常显不足。

3.How?

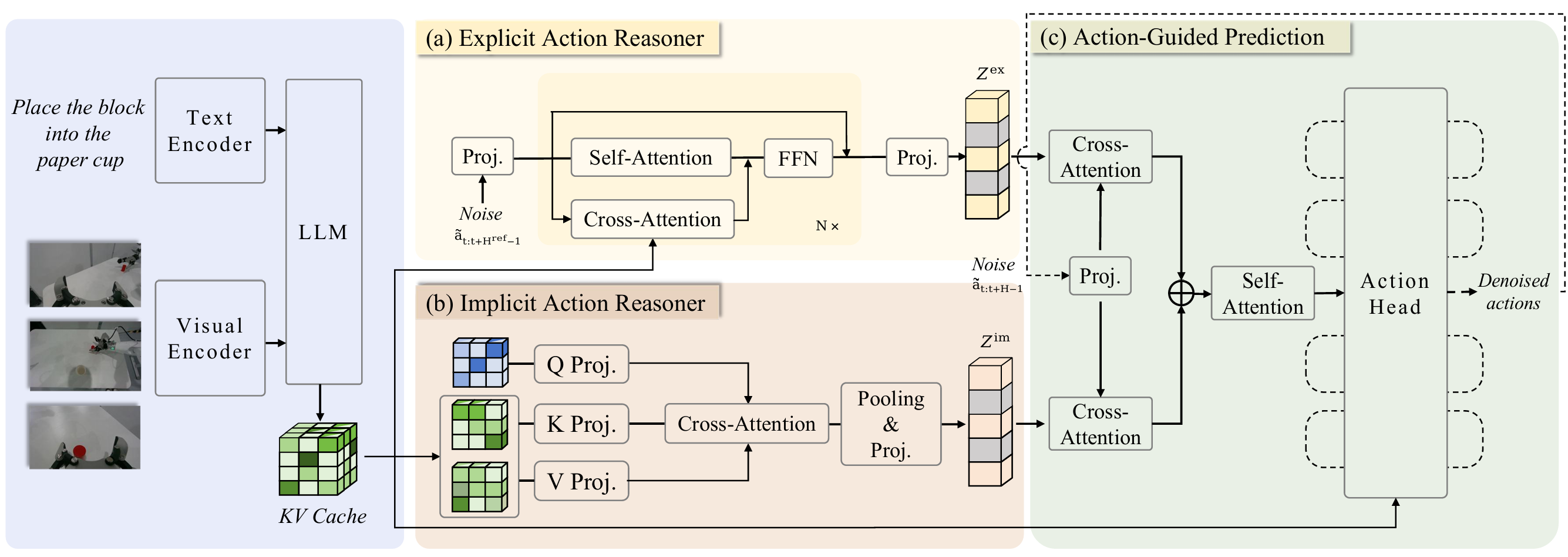

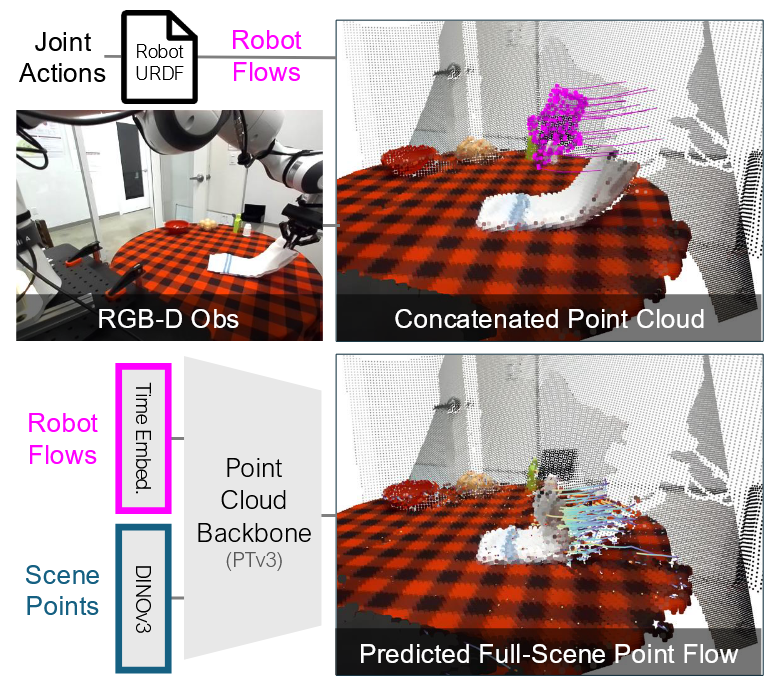

动作表征 采用三维点流方法。但与通过RGB-D采集获得的场景点流不同,机器人点流是通过其URDF文件(已知先验信息)进行正向运动学计算,预测机器人自身几何形态而生成的。

动态预测 未设计定制化架构,而是刻意基于前沿点云骨干网络构建,以提炼实现可扩展大规模三维世界建模的核心原理。为此目标,我们将初始场景点与时间堆叠的机器人点拼接成单一的点云输入骨干网络处理。场景点云通过投影至二维视图然后用冻结的DINOv3编码器进行特征提取,机器人点则使用时序嵌入进行特征化。点云骨干网络处理拼接后的点云并输出所有点的特征。通过稳定的回归损失训练大型三维世界模型。共享MLP头随后在单次前向传播中预测长度为H的时间段内每个时间步的场景点逐点位移。

状态表示。构建世界模型需要审慎选择状态空间S,其时刻t的状态记为st ∈ S。本研究中采用点流(亦称粒子)作为环境状态。

真机数据:主要基于DROID数据集——这是一个通过两台外部相机和一台腕戴式相机录制的多样化真实场景交互机器人操控数据集。虽然DROID提供了传感器深度和相机外参,但其深度在开放世界环境中常出现退化,且相机姿态因标定不完善而不够精确。前沿三维重建模型(如VGGT)虽能从RGB图像联合估计深度与相机参数,且视觉效果通常合理,但会产生过度平滑的深度图,其相机姿态也可能偏离真值数十厘米。经过大量实验,我们采用三阶段标注流程,将多个学习模型与专用优化程序相结合:首先,使用FoundationStereo的立体估计深度替代传感器深度,该方法在典型操控任务的近距离工作范围内尤为有效;其次,通过优化程序精修VGGT初始化的相机姿态,将机器人深度观测值与已知机器人网格模型对齐,从而计算相机外参;最后,在获得精确深度和外参的基础上,我们使用CoTracker3进行逐像素点追踪。CoTracker3是一种输出图像空间对应关系与可见性图的二维点追踪器;我们利用优化后的深度与相机位姿将这些轨迹提升至三维空间,并保留可见性标签,从而在模型训练时将遮挡点排除在监督信号之外。通过此流程,我们在超过60%的DROID数据(近200小时原始人类遥操作数据)中恢复了可靠的三维点轨迹,并获得在质量与数量上均优于原始数据集及其他标注方法的重建点云。

仿真数据(BEHAVIOR-1K)。为补充真实世界数据,我们采用BEHAVIOR-1K(B1K),该数据集在照片级真实的家居尺度环境中提供了约1100小时经过预筛选的遥操作交互数据,涵盖双手、全身及移动操作。我们通过已知仿真状态获取真值三维点轨迹。由于该数据集关注长时程活动,而POINTWORLD聚焦短时程交互动态,我们利用仿真中的特权信息对轨迹进行筛选。仅保留机器人-物体间存在主动接触及物体发生非零运动的轨迹。

4.Takeaways:

骨干网络、训练目标、预训练特征和模型缩放——共同带来了相对于原始GBND基线的显著提升。

增加数据与提升容量能带来可预测的性能增益。

泛化性与迁移能力研究:

在域内表现出良好的泛化能力,这表明POINTWORLD并非简单记忆训练样本。

使用真实世界数据训练能获得更好的迁移效果,这可能源于真实数据具有更高的场景多样性。

若以20倍少的更新步数微调可超越专用模型,并能从真实-仿真协同训练中获益。我们预留了DROID中CLVR实验室的数据,评估基于剩余DROID数据预训练的模型对该实验室的泛化性能。预留数据集按90%训练与10%测试划分。零样本模型从未接触这些帧,而微调变体仅使用90%训练子集。基于剩余DROID数据预训练的POINTWORLD,其性能与专门训练的模型持平。

局限性&未来工作

PointWorld | arxiv 2026.01.07 | Paper Reading