MemoryVLA | ICLR 2026 | Paper Reading

MEMORYVLA: PERCEPTUAL-COGNITIVE MEMORY IN VISION-LANGUAGE-ACTION MODELS FOR ROBOTIC MANIPULATION

这篇文章提出了将memory引入VLA中,从而解决VLA的灾难性遗忘问。

| 工作类型(首次/改进) | 技术路线 | 创新点 | 日期 |

|---|---|---|---|

| 首次 | VLA+Memory | Memory | 2025-11-23 |

1.What?

一种用于长时程机器人操作的认知-记忆-行动框架。

2.Why?

主流 VLA 模型如 OpenVLA和 π0仅依赖当前观测,因而忽略了时间依赖性,在长时序操控任务上表现不佳。如按下按钮任务在按压前后几乎无视觉差异,导致难以判断动作是否已完成。这凸显了操控任务的非马尔可夫性,即先前的动作会影响后续决策,亟需时序建模。一种简单策略是将连续帧拼接作为 VLM 输入,但其面临两个关键局限:

(1)自注意力机制的二次复杂度严重限制了可用的时序上下文长度;

(2)序列帧输入与模型单帧机器人预训练分布存在偏差。

3.How?

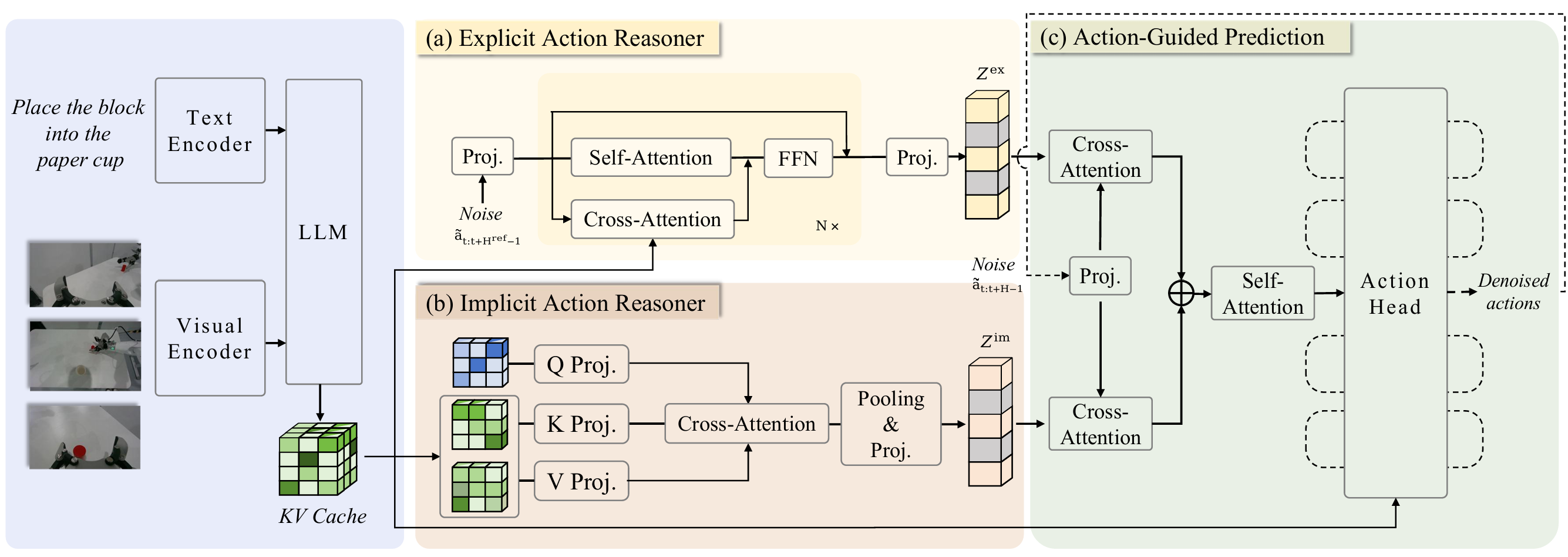

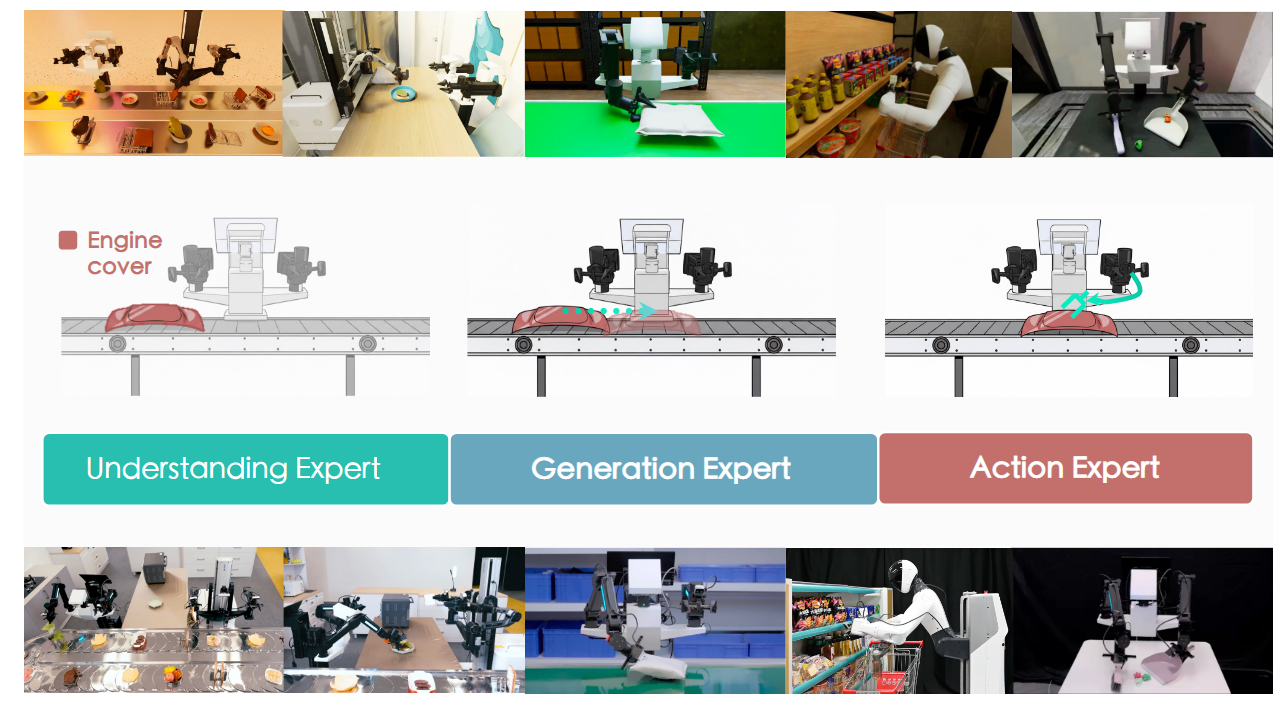

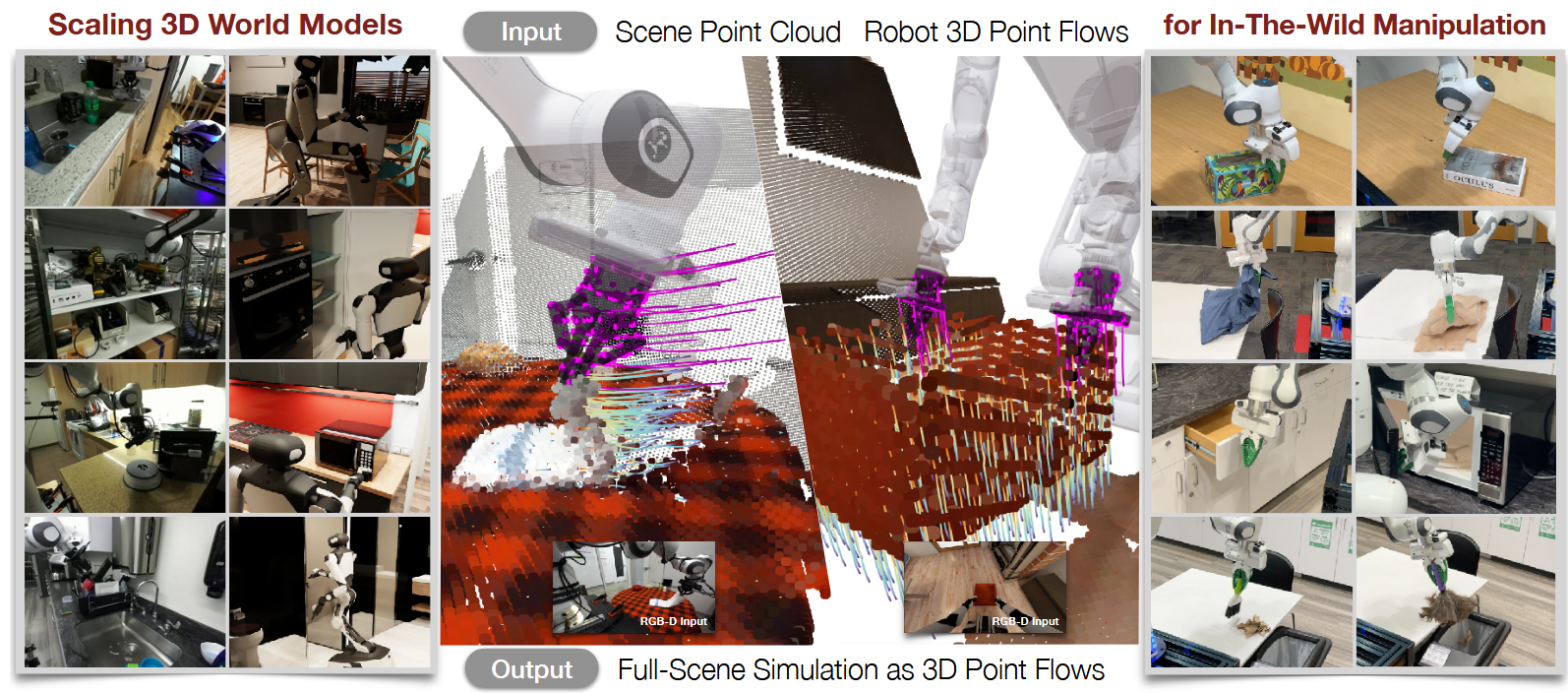

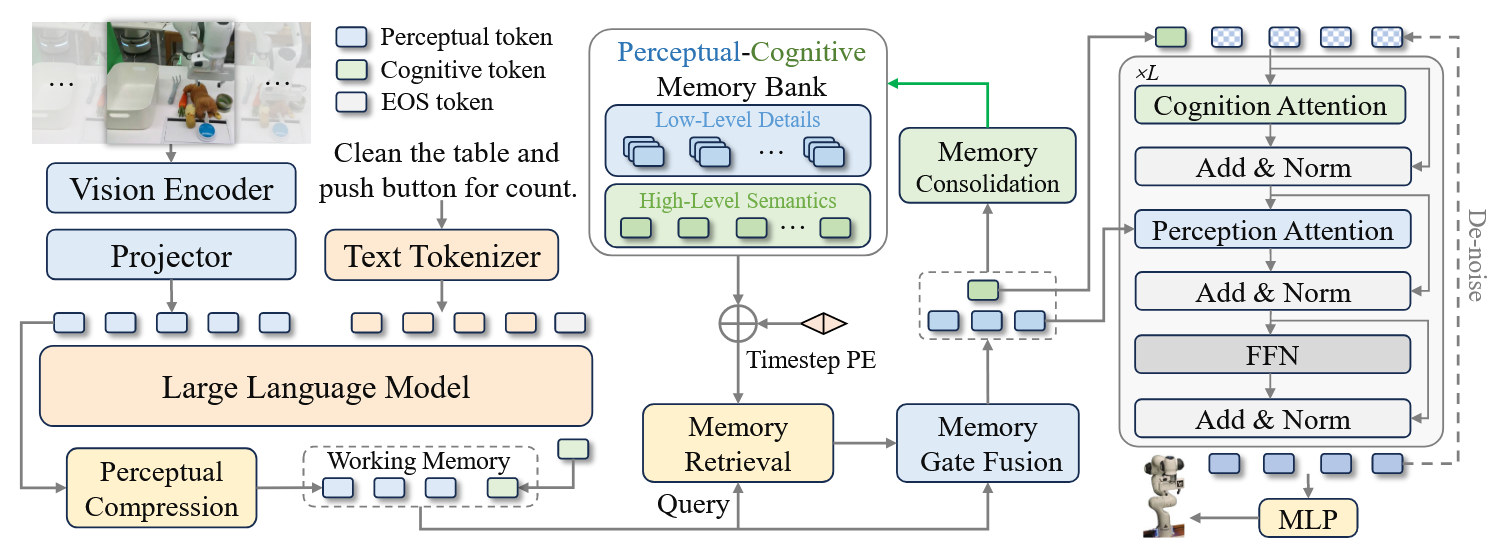

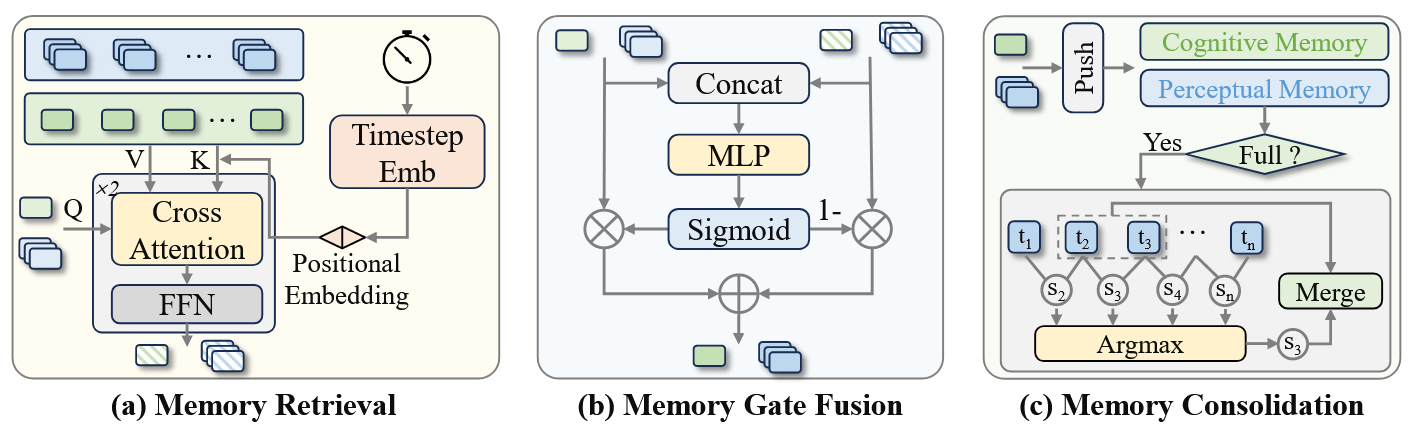

RGB观测数据与语言指令由70亿参数视觉语言模型编码为感知与认知令牌,构成短期工作记忆。工作记忆通过查询感知-认知记忆库检索相关历史上下文(包含高层语义与底层视觉细节),将其与当前令牌自适应融合,并通过合并最相似邻居实现记忆库的持续整合。经记忆增强的令牌随后作为条件输入扩散变换器,以预测未来动作序列。

4.Takeaways:

将Memory用到VLA领域的文章,感觉比较新可以follow

设计了一个具备工作记忆的感知‑认知记忆库,它能够跨高层认知与底层感知检索与决策相关的上下文信息,通过记忆融合自适应地将其与当前表征结合,并借助记忆巩固机制合并时序相邻、语义相似的条目

局限性:

目前还只是单任务记忆无法跨任务

未来工作

(一)开发记忆反射机制,将长期记忆对齐至大语言模型输入空间,实现嵌入空间的思维链推理;

(二)通过受生物启发的记忆巩固机制构建终身记忆系统,将频繁重用的经验提炼为永久表征,从而支持跨场景、跨任务、跨具身形态的可扩展泛化能力。

MemoryVLA | ICLR 2026 | Paper Reading